форкнуто от main/is_dnn

Вы не можете выбрать более 25 тем

Темы должны начинаться с буквы или цифры, могут содержать дефисы(-) и должны содержать не более 35 символов.

12 KiB

12 KiB

Отчет по лабораторной работе № 1

Киселёв Матвей, Мамедов Расул А-01-22

1) В среде Google Colab создать новый блокнот (notebook). Импортировать необходимые для работы библиотеки и модули.

import os

os.chdir('/content/drive/MyDrive/Colab Notebooks')

# импорт модулей

from tensorflow import keras

import matplotlib.pyplot as plt

import numpy as np

import sklearn

2) Загрузить набор данных MNIST, содержащий размеченные изображения рукописных цифр.

# загрузка датасета

from keras.datasets import mnist

(X_train, y_train), (X_test, y_test) = mnist.load_data()

3) Разбить набор данных на обучающие и тестовые данные в соотношении 60 000:10 000 элементов. При разбиении параметр random_state выбрать равным (4k – 1), где k – номер бригады. Вывести размерности полученных обучающих и тестовых массивов данных.

# создание своего разбиения датасета

from sklearn.model_selection import train_test_split

# объединяем в один набор

X = np.concatenate((X_train, X_test))

y = np.concatenate((y_train, y_test))

# разбиваем по вариантам

X_train, X_test, y_train, y_test = train_test_split(X, y,

test_size = 10000,

train_size = 60000,

random_state = 4*6 -1)

# вывод размерностей

print('Shape of X train:', X_train.shape)

print('Shape of y train:', X_train.shape)

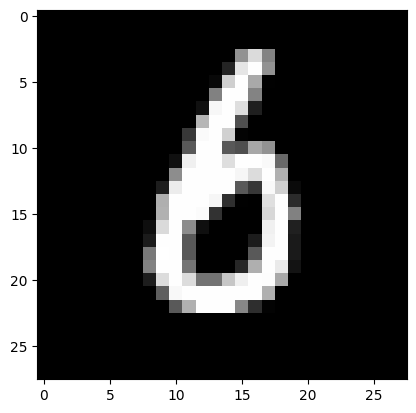

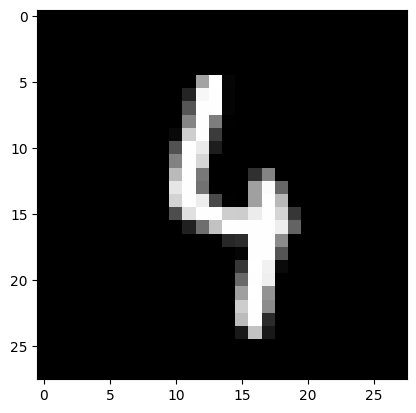

4) Вывести первые 4 элемента обучающих данных (изображения и метки цифр).

for i in [0,1,2,3]:

# вывод изображения

plt.imshow(X_train[i], cmap=plt.get_cmap('gray'))

plt.show()

# вывод метки для этого изображения

print(y_train[i])

6

4

4

3

5) Провести предобработку данных: привести обучающие и тестовые данные к формату, пригодному для обучения нейронной сети. Входные данные должны принимать значения от 0 до 1, метки цифр должны быть закодированы по принципу «one-hot encoding». Вывести размерности предобработанных обучающих и тестовых массивов данных.

# развернем каждое изображение 28*28 в вектор 784

num_pixels = X_train.shape[1] * X_train.shape[2]

X_train = X_train.reshape(X_train.shape[0], num_pixels) / 255

X_test = X_test.reshape(X_test.shape[0], num_pixels) / 255

print('Shape of transformed X train:', X_train.shape)

# переведем метки в one-hot

from keras.utils import to_categorical

y_train = keras.utils.to_categorical(y_train)

y_test = keras.utils.to_categorical(y_test)

print('Shape of transformed y train:', y_train.shape)

num_classes = y_train.shape[1]

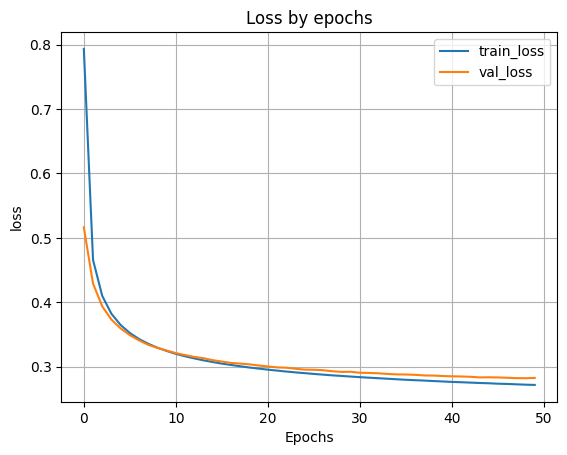

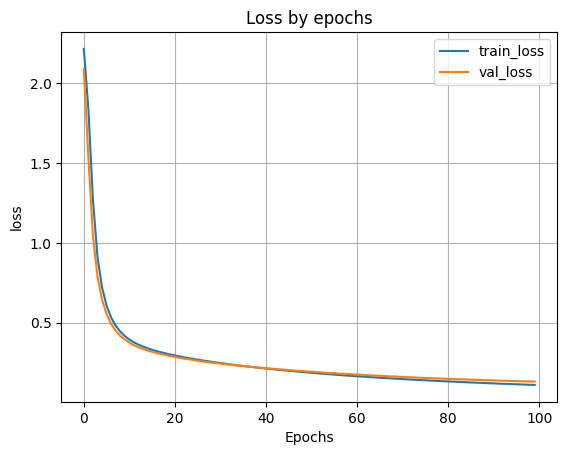

6) Реализовать модель однослойной нейронной сети и обучить ее на обучающих данных с выделением части обучающих данных в качестве валидационных. Вывести информацию об архитектуре нейронной сети. Вывести график функции ошибки на обучающих и валидационных данных по эпохам.

from keras.models import Sequential

from keras.layers import Dense

# 1. создаем модель - объявляем ее объектом класса Sequential

model = Sequential()

# 2. добавляем выходной слой

model.add(Dense(units=num_classes, activation='softmax'))

# 3. компилируем модель

model.compile(loss='categorical_crossentropy', optimizer='sgd', metrics=['accuracy'])

# вывод информации об архитектуре модели

print(model.summary())

# Обучаем модель

H = model.fit(X_train, y_train, validation_split=0.1, epochs=50)

7) Применить обученную модель к тестовым данным. Вывести значение функции ошибки и значение метрики качества классификации на тестовых данных.

# вывод графика ошибки по эпохам

plt.plot(H.history['loss'])

plt.plot(H.history['val_loss'])

plt.grid()

plt.xlabel('Epochs')

plt.ylabel('loss')

plt.legend(['train_loss', 'val_loss'])

plt.title('Loss by epochs')

plt.show()

# Оценка качества работы модели на тестовых данных

scores = model.evaluate(X_test, y_test)

print('Loss on test data:', scores[0])

print('Accuracy on test data:', scores[1])

Сеть без скрытых слоёв:

Оценка качества работы:

Loss on test data: 0.2811441123485565

Accuracy on test data: 0.9204000234603882

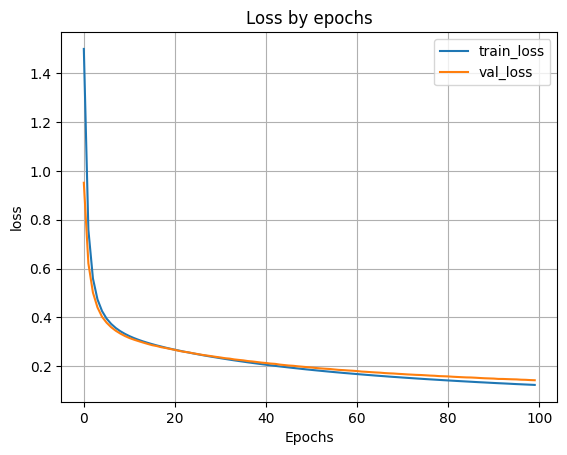

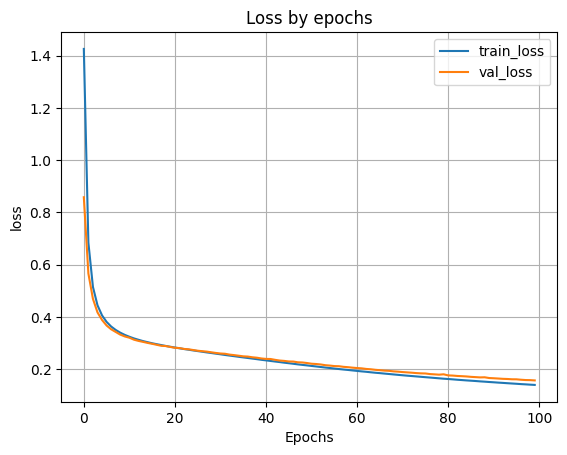

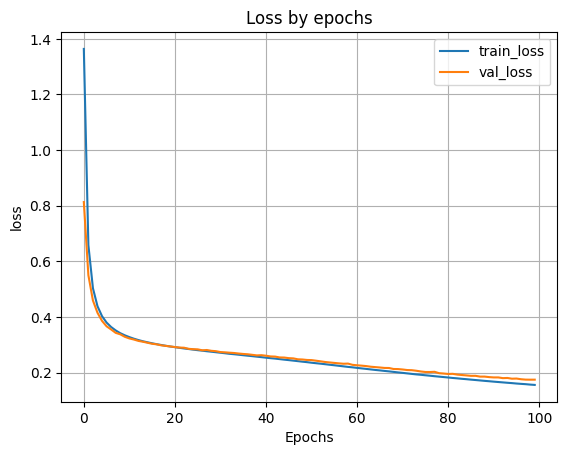

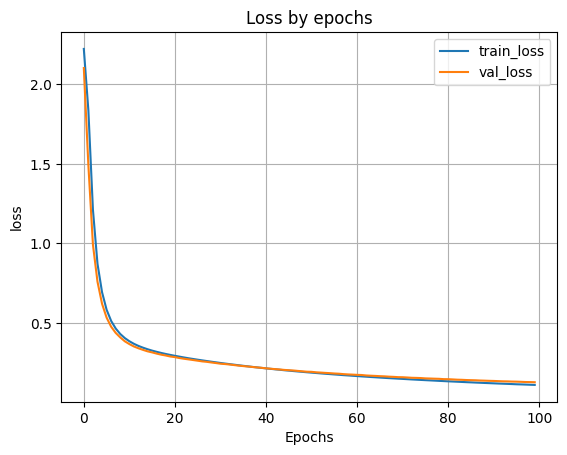

8) Добавить в модель один скрытый и провести обучение и тестирование (повторить п. 6–7) при 100, 300, 500 нейронах в скрытом слое. По метрике качества классификации на тестовых данных выбрать наилучшее количество нейронов в скрытом слое. В качестве функции активации нейронов в скрытом слое использовать функцию sigmoid.

# добавляем первый скрытый слой

model.add(Dense(units=100, input_dim=num_pixels, activation='sigmoid'))

100 нейронов в 1 скрытом слое:

300 нейронов в 1 скрытом слое:

500 нейронов в 1 скрытом слое:

Вывод: по наибольшей метрике качества классификации на тестовых данных можно определить, что лучшее количество нейронов в скрытом слое - 100.

9) Добавить в наилучшую архитектуру, определенную в п. 8, второй скрытый слой и провести обучение и тестирование (повторить п. 6–7) при 50 и 100 нейронах во втором скрытом слое. В качестве функции активации нейронов в скрытом слое использовать функцию sigmoid.

# добавляем второй скрытый слой

model.add(Dense(units=50, activation='sigmoid'))

100 нейронов в 1 скрытом слое и 50 во 2 скрытом слое:

100 нейронов в 1 скрытом слое и 100 во 2 скрытом слое:

10) Результаты исследования архитектуры нейронной сети занести в таблицу:

| Кол-во скрытых слоев | Нейроны в 1 слое | Нейроны во 2 слое | Точность |

|---|---|---|---|

| 0 | - | - | 0.9204 |

| 1 | 100 | - | 0.9592 |

| 1 | 300 | - | 0.9536 |

| 1 | 500 | - | 0.9488 |

| 2 | 100 | 50 | 0.9618 |

| 2 | 100 | 100 | 0.9603 |

Вывод: как видно из таблицы, наилучший результат показала нейросеть с двумя скрытыми слоями, у которой 100 нейронов в первом скрытом слое и 50 во втором.

11) Сохранить наилучшую нейронную сеть на диск. Данную нейронную сеть потребуется загрузить с диска в одной из следующих лабораторных работ.

model.save('best_model.keras')

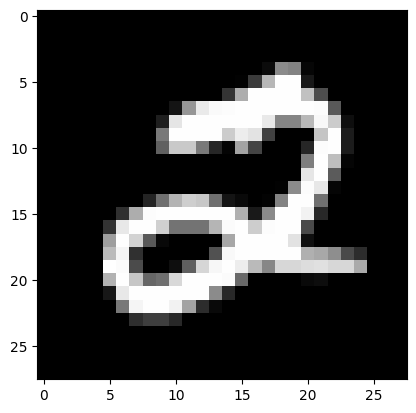

12) Для нейронной сети наилучшей архитектуры вывести два тестовых изображения, истинные метки и результат распознавания изображений.

result = model.predict(X_test[n:n+1])

print('NN output:', result)

plt.imshow(X_test[n].reshape(28,28), cmap=plt.get_cmap('gray'))

plt.show()

print('Real mark: ', str(np.argmax(y_test[n])))

print('NN answer: ', str(np.argmax(result)))

Real mark: 2

NN answer: 2

Real mark: 0

NN answer: 0

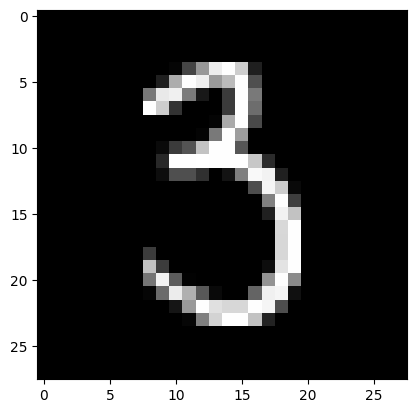

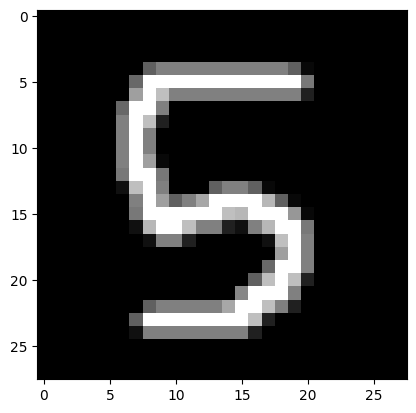

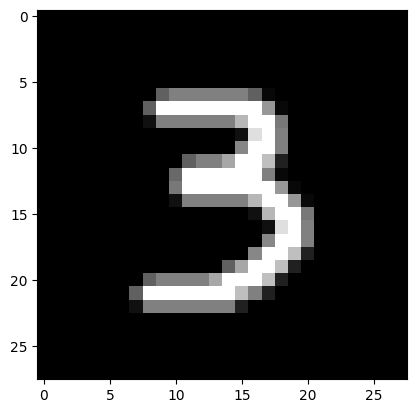

13) Каждому члену бригады создать собственное изображение рукописной цифры, подобное представленным в наборе MNIST. Цифру выбрать как остаток от деления на 10 числа своего дня рождения (например, 29 февраля → 29 mod 10 = 9). Сохранить изображения. Загрузить, предобработать и подать на вход обученной нейронной сети собственные изображения. Вывести изображения и результаты распознавания.

# загрузка собственного изображения

from PIL import Image

file_data = Image.open('test5.png')

file_data = file_data.convert('L') # перевод в градации серого

test_img = np.array(file_data)

# вывод собственного изображения

plt.imshow(test_img, cmap=plt.get_cmap('gray'))

plt.show()

# предобработка

test_img = test_img / 255

test_img = test_img.reshape(1, num_pixels)

# распознавание

result = model.predict(test_img)

print('I think it\'s ', np.argmax(result))

I think it`s 5

I think it`s 3

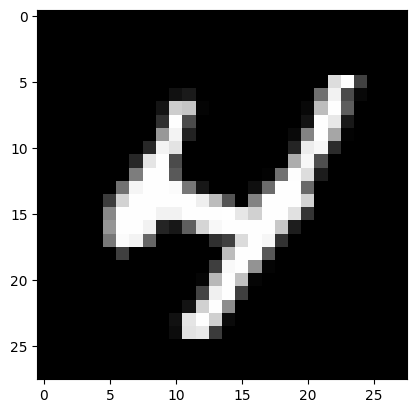

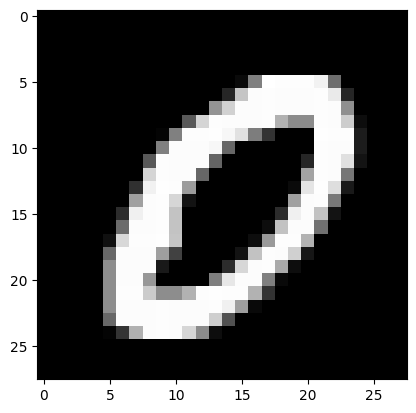

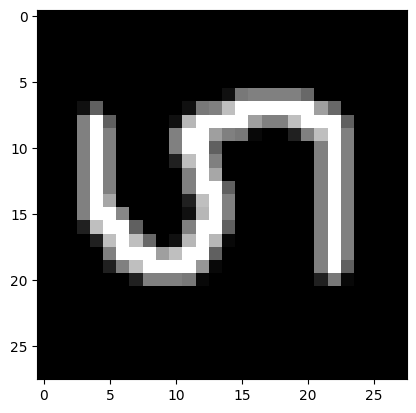

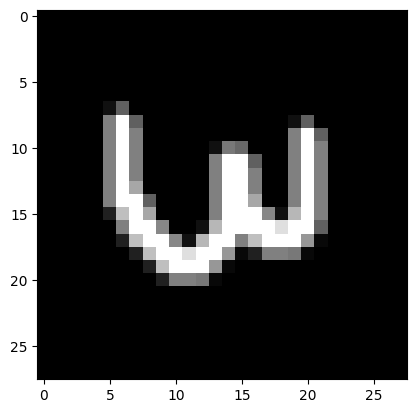

14) Каждому члену бригады создать копию собственного изображения, отличающуюся от оригинала поворотом на 90 градусов в любую сторону. Сохранить изображения. Загрузить, предобработать и подать на вход обученной нейронной сети измененные изображения. Вывести изображения и результаты распознавания. Сделать выводы по результатам эксперимента.

from PIL import Image

file_data = Image.open('test5per.png')

file_data = file_data.convert('L') # перевод в градации серого

test_img = np.array(file_data)

I think it`s 8

I think it`s 4